Wer hat das nicht schon erlebt? Man stellt einer KI eine Frage und erhält eine Antwort, die verblüffend selbstbewusst, aber leider völlig falsch ist. Diese Momente, in denen die Technologie scheinbar „kreativ“ wird und Fakten erfindet, wird KI-Halluzinationen genannt.

Während das im Alltag oft nur ein Ärgernis oder eine Kuriosität ist, wird es im professionellen Umfeld zum ernsten Problem. Besonders für Institutionen, deren Kernaufgabe auf geprüften Fakten und öffentlichem Vertrauen basiert, wie Museen, sind solche Halluzinationen nicht tragbar.

Was sind KI-Halluzinationen?

Der Begriff „KI-Halluzination“ beschreibt ein Phänomen, bei dem ein KI-Modell scheinbar überzeugende, aber falsche oder frei erfundene Informationen generiert.

Wie IBM erklärt, entstehen solche Fehler, wenn ein Large Language Model (LLM) Muster „wahrnimmt“, die in den Trainingsdaten gar nicht existieren und daraus Inhalte ableitet, die nicht der Realität entsprechen (IBM, 2024).

Im Unterschied zu einem klassischen Programmierfehler „denkt“ die KI sich also nichts bewusst aus, sondern berechnet die wahrscheinlichste Antwort auf Grundlage ihrer Trainingsdaten. Wenn diese Daten unvollständig oder verzerrt sind, entsteht eine scheinbar plausible, aber faktisch falsche Aussage, eine Halluzination.

Warum halluzinieren LLMs?

Große Sprachmodelle werden darauf trainiert, die wahrscheinlichste Wortfolge vorherzusagen. Sie verstehen Inhalte nicht im menschlichen Sinn, sondern berechnen Wahrscheinlichkeiten.

Da sie auf vorgegebenen Datensätzen mit begrenztem „Knowledge Cutoff“ basieren, fehlen ihnen aktuelle oder spezifische Fakten.

Wenn ein Modell also keine verlässliche Information „kennt“, füllt es die Lücke und erzeugt eine Antwort, die zwar flüssig klingt, aber nicht auf überprüfbaren Quellen basiert.

Solche Halluzinationen können auch durch Bias in Trainingsdaten, Fehlinterpretationen bei der Texterzeugung oder fehlende Einschränkungen im Promptdesign entstehen.

Warum ist das für Museen problematisch?

Museen sind Orte, an denen Besucher:innen hochwertige, geprüfte Informationen erwarten.

Eine Studie des Instituts für Museumsforschung (2023) zeigt: „Museen genießen in Deutschland das höchste Vertrauen aller Wissensinstitutionen“ (SMB, 2023).

Wenn Museen künftig KI-gestützte Systeme einsetzen, etwa Chatbots, Audioguides oder Besucherassistenten, steht dieses Vertrauen auf dem Spiel.

Eine KI, die historische Daten falsch interpretiert, einen Objektkontext erfindet oder gar sensible Themen verzerrt darstellt, kann Glaubwürdigkeit und Vertrauen langfristig beschädigen.

Gerade im Kulturbereich ist daher entscheidend:

Wer KI einsetzt, muss die Faktenbasis sichern.

Wie können Halluzinationen verhindert werden?

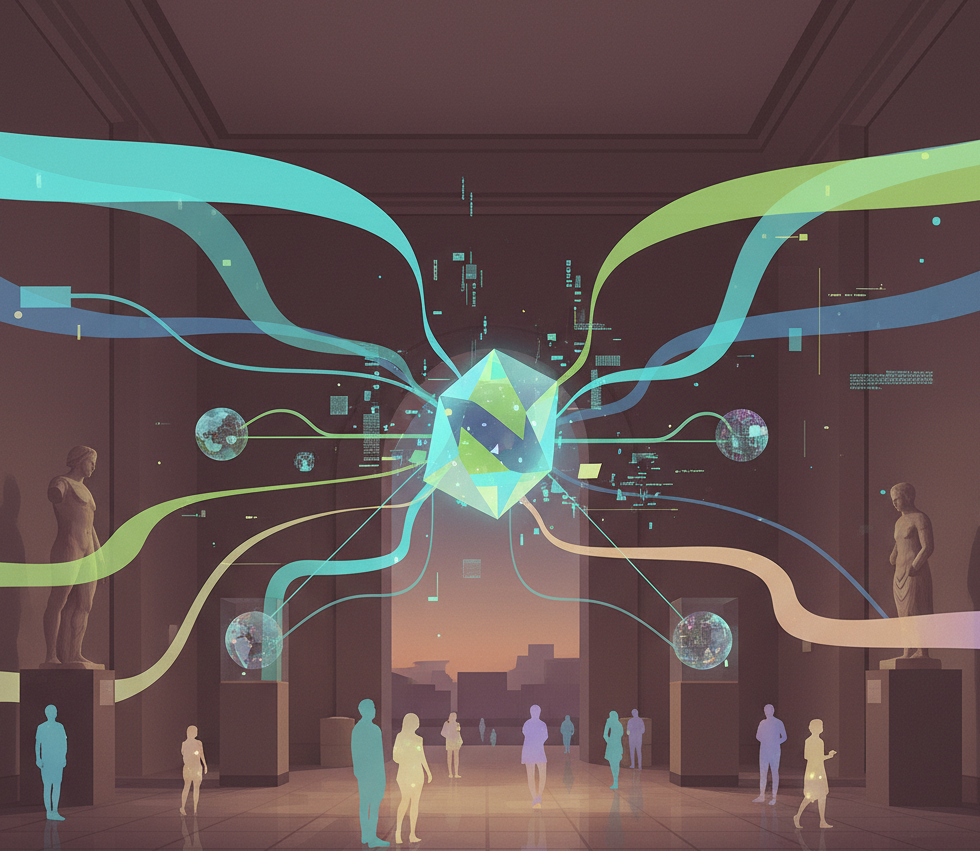

Eine bewährte Methode, um KI-Halluzinationen zu vermeiden, ist Retrieval-Augmented Generation (RAG) (Wikipedia_RAG).

RAG kombiniert zwei Schritte:

- Retrieval: Die KI durchsucht eine externe Wissensdatenbank oder Dokumentensammlung nach relevanten Informationen.

- Generation: Nur diese geprüften Inhalte werden in die Antwort eingebaut.

So bleibt die KI nicht auf ihr internes Sprachmodell beschränkt, sondern kann auf faktengeprüfte, aktuelle Quellen zurückgreifen.

RAG-Modelle werden zunehmend als Best Practice für wissensintensive Bereiche wie Medizin, Recht – und eben Museen – eingesetzt.

Unterschiedliche Anforderungen je nach Domain

Ein RAG-System funktioniert nicht universell gleich.

Je nach Einsatzgebiet müssen Such- und Antwortmechanismen angepasst werden:

- Museumsdatenbanken bestehen oft aus beschreibenden Texten, Metadaten, Provenienzinformationen und Objektbildern.

- Die Art der Fragen unterscheidet sich stark von typischen Web-Suchanfragen – Besucher:innen fragen etwa „Wer war diese Künstlerin?“ oder „Welche Bedeutung hat dieses Symbol?“.

- Auch die Art der Antwort erfordert Domänenwissen: Ein KI-Assistent muss nicht nur korrekt, sondern kontextsensibel und besucherfreundlich formulieren.

nuseum als Experte für RAG im Museumsbereich

nuseum entwickelt KI-gestützte Museums-Guides, die speziell für diese Anforderungen konzipiert sind.

Der nuseum Copilot nutzt ein auf die Museumsdomäne zugeschnittenes RAG-System:

Er greift auf kuratierte Datenquellen und geprüfte Objektinformationen zu, bevor er eine Antwort generiert.

So kann der Chatbot fehlendes Hintergrundwissen der Besucher:innen ergänzen, ohne Inhalte zu erfinden.

Durch die Kombination aus technischer RAG-Expertise und Verständnis musealer Vermittlungspraxis unterstützt nuseum Museen dabei, KI sicher einzusetzen, als Werkzeug zur Wissensvermittlung, nicht als Risiko für ihre Glaubwürdigkeit.

Fazit

KI-Halluzinationen sind kein Randphänomen, sondern ein strukturelles Risiko generativer Modelle.

Gerade Museen, die als vertrauenswürdige Wissensorte gelten, müssen sicherstellen, dass digitale Vermittlungsangebote faktenbasiert bleiben.

Technologien wie Retrieval-Augmented Generation bieten hier eine zukunftsweisende Lösung:

Sie verbinden maschinelle Sprachkompetenz mit kuratorischer Verantwortung.

nuseum zeigt, wie sich beides in der Praxis vereinen lässt, für digitale Assistenten, die Besucherfragen verlässlich, kontextgenau und glaubwürdig beantworten.